Bei Frontis Energy haben wir viel darüber nachgedacht, wie man CO2 wiederverwerten kann. Während hochwertige Produkte wie Polymere für medizinische Anwendungen rentabler sind, ist die Nachfrage nach solchen Produkten zu gering, um CO2 in großen Mengen wiederzuverwertten. Das ist aber nötig, um die CO2-Konsentration unserer Atmosphäre auf ein vorindustrielles Niveau zu bringen. Biokraftstoffe, zum Beispiel aus Biomasse, wurden seit langem als Lösung vorgeschlagen. Leider benötigt Biomasse sie zu viel Ackerland. Zudem ist die zugrundeliegende Biochemie zu komplex, um sie in Ihrer Gesamtheit zu verstehen und so effektive Lösungen zu implementieren. Daher schlagen wir einen anderen Weg vor, um das Ziel der Dekarbonisierung unseres Planeten schnell zu erreichen. Das vorgeschlagene Verfahren beginnt mit einem gewünschten Zielkraftstoff und schlägt eine mikrobielle Vergesellschaftung vor, um diesen Kraftstoff herzustellen. In einem zweiten Schritt wird das mikrobielle Konsortium in einem bioelektrischen Reaktor (BER) untersucht.

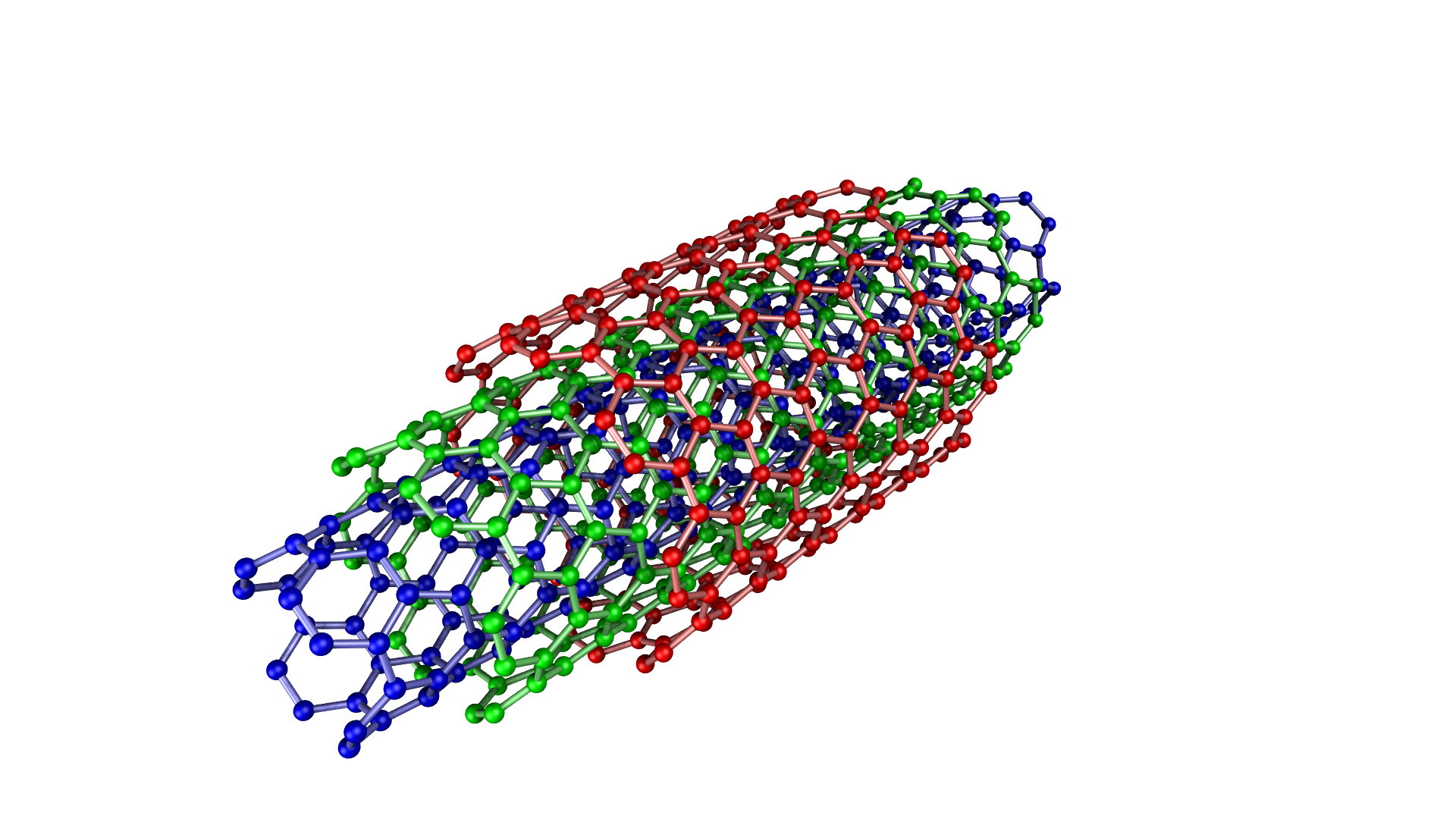

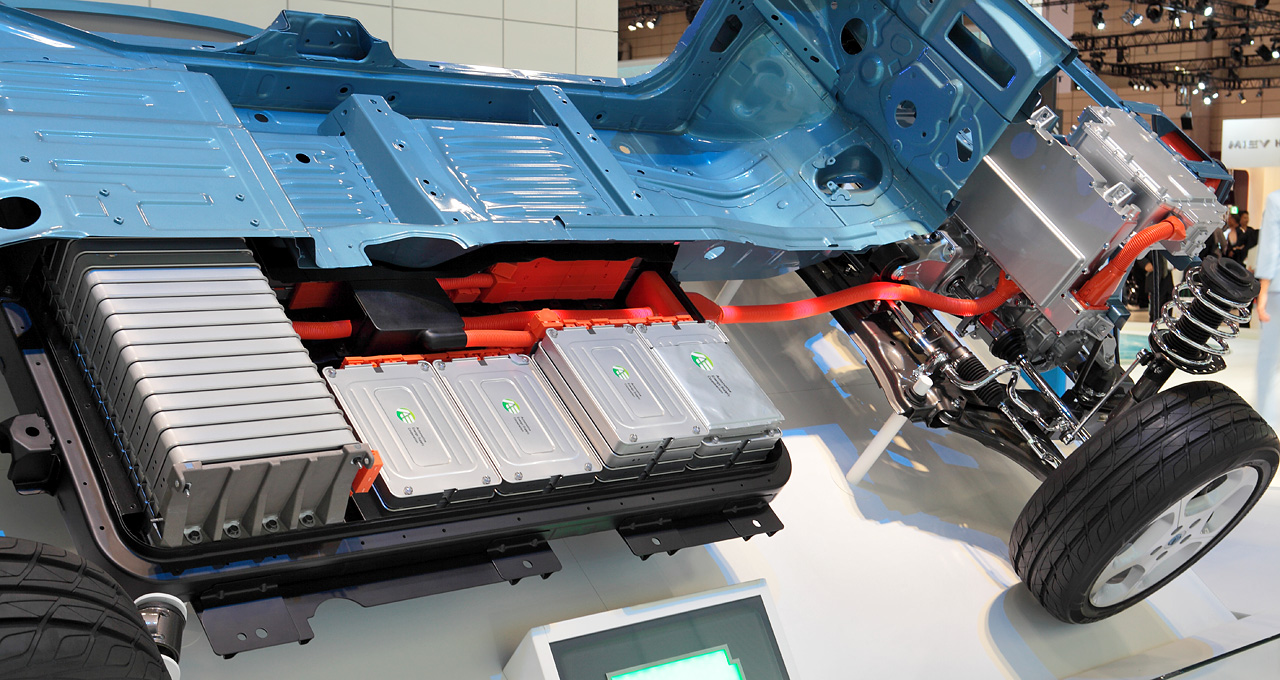

Unser heutiges atmosphärische CO2-Ungleichgewicht ist die direkte Folge der Verbrennung fossiler Kohlenstoffe. Diese Realität erfordert schnelle und pragmatische Lösungen, um einen weitere CO2-Anstieg zu verhindern. Die direkte Abscheidung von CO2 aus der Luft ist schon bald rentabel. Dadurch wird die Nutzung von Ackerland für den Anbau von Treibstoff verhindert. Die Herstellung von Kraftstoff für Verbrennungsmotoren mit CO2 also Ausgangsmaterial ist kurzfristig die beste Zwischenlösung, da sich dieser Kraftstoff nahtlos in die vorhandene städtische Infrastruktur integriert. Biokraftstoffe wurden in den letzten Jahren intensiv erforscht, insbesondere auf dem neuen Gebiet der synthetischen Biologie. So verführerisch die Anwendung gentechnisch veränderter Organismen (GVO) zu sein scheint, so sind doch traditionell gezüchtete mikrobielle Stämme bereits vorhanden und somit sofort verfügbar. Unter Vermeidung von GVO, wird CO2 bereits heute in BER zur Herstellung von C1-Kraftstoffen wie Methan verwendet. BER können auch zur Herstellung von Kraftstoffvorläufern wie Ameisensäure oder Synthesegas, sowie C1+ -Verbindungen wie Acetat, 2-Oxybutyrat, Butyrat, Ethanol und Butanol eingesetzt werden. Gleichzeitig lassen sich BER gut in die städtische Infrastruktur integrieren, ohne daß kostbares Ackerland benötigt wird. Mit Ausnahme von Methan ist jedoch keiner der vorgenannten bioelektrischen Kraftstoffen (BEKS) in reiner Form leicht brennbar. Während Elektromethan eine im Handel erhältliche Alternative zu fossilem Erdgas ist, ist seine volumetrische Energiedichte von 40-80 MJ/m3 niedriger als die von Benzin mit 35-45 GJ/m3. Abgesehen davon, wird Methan als Kraftstoff von den meisten Automobilnutzern nicht gekauft. Um flüssigen Brennstoff herzustellen, müssen Kohlenstoffketten mit Alkoholen oder besser Kohlenwasserstoffen als Endprodukten verlängert werden. Zu diesem Zweck ist Synthesegas (CO + H2) eine theoretische Option und kann durch die Fischer-Tropsch-Synthese gewonnen werden. Tatsächlich sind Synthesegasvorläufer aber entweder fossile Brennstoffe (z. B. Kohle, Erdgas, Methanol) oder Biomasse. Während fossile Kraftstoffe offensichtlich nicht CO2-neutral sind, benötigt man zur Herstellung von Biomasse Ackerland. Die direkte Umwandlung von CO2 und elektrolytischen Wasserstoff in C1+ -Kraftstoffe wird wiederum durch elektroaktive Mikroben im Dunkeln katalysiert (siehe Titelbild). Dadurch wird die Konkurrenz zwischen Nahrungsmittelanbau und Kraftstoffpflanzen vermieden. Leider wurde nur bislang wenig anwendbares zu elektroaktiver Mikroben erforscht. Im Gegensatz dazu gibt es eine Vielzahl von Stoffwechselstudien über traditionelle mikrobielle Kraftstoffproduzenten. Diese Studien schlagen häufig die Verwendung von GVO oder komplexen organischen Substraten als Vorläufer vor. Bei Frontis Energy gehen wir einen anderen weg. Wir ermitteln systematisch Stoffwechselwege für die Produktion von flüssigem BEKS. Der schnellste Ansatz sollte mit einem Screening von metabolischen Datenbanken mit etablierten Methoden der metabolischen Modellierung beginnen, gefolgt von Hochdurchatztestsin BER. Da Wasserstoff das Zwischenprodukt in der Bioelektrosynthese ist, besteht die effizienteste Strategie darin, CO2 und H2 als direkte Vorläufer mit möglichst wenigen Zwischenschritten zu benutzen. Skalierbarkeit und Energieeffizienz, also wirtschaftliche Machbarkeit, sind dabei entscheident.

Das größte Problem bei der die BEKS-Produktion ist das mangelnde Wissen über Wege, die CO2 und elektrolytisches H2 verwenden. Diese Lücke besteht trotz umfangreicher Stoffwechseldatenbanken wie KEGG und KBase, wodurch die Auswahl geeigneter BEKS-Stämme einem Stochern im Nebel gleichkommt. Trotz der hohen Komplexität wurden Stoffwechselmodelle verwendet, um Wege zur Kraftstoffproduktion in Hefen und verschiedenen Prokaryoten aufzuzeigen. Trotz ihrer Unzulänglichkeiten wurden Stoffwechelatenbanken breits eingesetzt, um Artwechselwirkungen zu modellieren, z.B. mit ModelSEED / KBase (http://modelseed.org/) in einer heterotrophen Algenvergesellschaftung, mit RAVEN / KEGG oder mit COBRA. Ein erster systematischer Versuch für acetogene BEKS-Kulturen, bewies die die Verwendbarkeit von KBase für BER. Diese Forschung war eine Genomstudie der vorhandenen BEKS-Konsortien. Dieselbe Software kann auch in umgekehrt eingesetzt werden, beginnend mit dem gewünschten Brennstoff. Im Ergebnis werden dann die erforderlichen Organismen benannt. Wir beschrieben nun einige BEKS-Kulturen.

Hefen gehören zu den Mikroorganismen mit dem größten Potenzial für die Produktion von flüssigem Biokraftstoff. Bäckerhefe (Saccharomyces cerevisiae) ist das prominenteste Beispiel. Hefen sind zwar für die Ethanolfermentation bekannt, produzieren aber auch Fuselöle wie Butan, Phenyl- und Amylderivate, Aldehyde und Alkohole. Im Gegensatz zu Ethanol, das durch Zuckerfermentation gebildet wird, wird Fuselöl im Aminosäurestoffwechsel synthetisiert, gefolgt von Aldehydreduktion. Es wurden viele Enzyme identifiziert, die an der Reduktion von Aldehyden beteiligt sind, wobei Alkoholdehydrogenasen am häufigsten beobachtet werden. Die entsprechenden Reduktionsreaktionen erfordern reduziertes NADH, es ist jedoch nicht bekannt, ob an Kathoden gebildetes H2 daran beteiligt sein kann.

Clostridien, beispielsweise Clostridium acetobutylicum und C. carboxidivorans, können Alkohole wie Butanol, Isopropanol, Hexanol und Ketone wie Aceton aus komplexen Substraten (Stärke, Molke, Cellulose usw.) oder aus Synthesegas herstellen. Der Clostridienstoffwechsel wurde vor einiger Zeit aufgeklärt und unterscheidet sich von Hefe. Er erfordert nicht zwangsläufig komplexe Substrate für die NAD+-Reduktion, denn es wurde gezeigt, daß Wasserstoff, Kohlenmonoxid und Kathoden Elektronen für die Alkoholproduktion abgeben können. CO2 und Wasserstoff wurden in einem GMO-Clostridium verwendet, um hohe Titer von Isobutanol herzustellen. Typische Vertreter für die Acetatproduktion aus CO2 und H2 sind C. ljungdahlii, C. aceticum und Butyribacterium methylotrophicum. Sporomusa sphaeroides produziert Acetat in BES. Clostridien dominierten auch in Mischkulturen in BER, die CO2 in Butyrat umwandelten. Sie sind daher vorrangige Ziele für eine kostengünstige Produktion von Biokraftstoffen. In Clostridien werden Alkohole über Acetyl-CoA synthetisiert. Diese Reaktion ist reversibel, wodurch Acetat als Substrat für die Biokraftstoffproduktion mit extrazellulärer Energieversorgung dienen kann. In diesem Fall wird die ATP-Synthese durch Elektronenbifurkation aus der Ethanoloxidation oder durch Atmung und Wasserstoffoxidation betrieben. Ob die Elektronenbifurkation oder Atmung mit Alkoholen oder der Ketonsynthese verknüpft sind ist nicht bekannt.

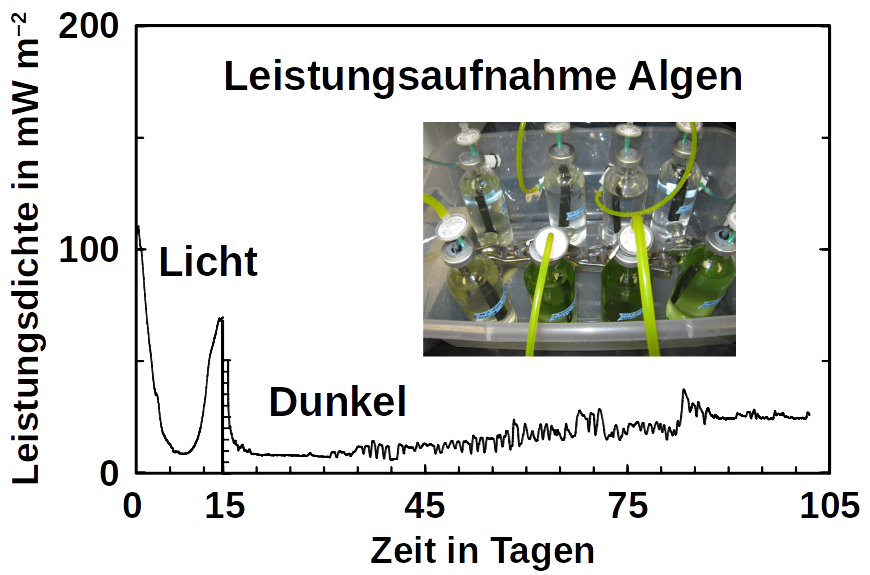

Phototrophe wie Botryococcus produzieren auch C1+ Biokraftstoffe. Sie synthetisieren eine Reihe verschiedener Kohlenwasserstoffe, darunter hochwertige Alkane und Alkene sowie Terpene. Hohe Titer wurden jedoch nur mithilfe von GVOs produziert, was in vielen Ländern aus rechtlichen Gründen ökonomisch schwer möglich ist. Darüber hinaus erfordert die Dehydratisierung / Deformylierung vom Aldehyd zum Alkan oder Alken molekularen Sauerstoff, was deren Produktion in BER unmoeglich macht, da Saurstoff bevorzugt die Kathode oxidiert. Der Olefinweg von Synechococcus hängt auch von molekularem Sauerstoff ab, wobei das Cytochrom P450 an der Fettsäuredecarboxylierung beteiligt ist. Die Anwesenheit von molekularem Sauerstoff beeinflußt die BES-Leistung auch durch den sofortigen Produktabbau. Im Gegensatz dazu zeigen unsere eigenen Vorversuche (siehe Titelfoto) und ein Korrosionsexperiment, daß Algen mit einer Kathode als Elektronendonor im Dunkeln leben können, selbst wenn geringe Mengen Sauerstoff vorhanden waren. Die an der Herstellung einiger Algenkraftstoffe beteiligten Enzyme sind zwar bekannt (wie die Deformylierung von Olefinen und Aldehyden), es ist jedoch nicht bekannt, ob diese Wege durch Wasserstoffnutzung beschritten werden können (möglicherweise über Ferredoxine). Ein solcher Zusammenhang wäre ein vielversprechender Hinweis für Kohlenwasserstoff-erzeugenden Cyanobakterien, die an Kathoden wachsen können. Unsere zukünftige Forschungen wird zeigen, ob wir hier richtig liegen.

Bei Frontis Energy glauben wir, daß eine Reihe anderer Mikroorganismen Potenzial zur BEKS-Produktion haben. Um nicht GVO zurückgreifen zu müssen, müssen BER-kompatible Mischkulturen über rechnergestützte Stoffwechselmodelle aus vorhandenen Datenbanken identifiziert werden. Mögliche Intermediate sind z.Z. unbekannt. Der Kenntnis ist aber Voraussetzung für profitable BEKS-Reaktoren.

Sie müssen angemeldet sein, um einen Kommentar zu veröffentlichen.